TOPS-Tier: Meisterhafte AI-Leistung, RTX-AI-PCs und -Workstations Decoded

Die Ära der AI-PCs bringt neue Möglichkeiten, AI-Leistung zu messen. Die Begriffe können bei der Auswahl zwischen den verfügbaren Desktop schwer zu verstehen sein, heute klärt NVIDIA über Schlagworte auf, die jeder AI-PC-Käufer einmal gehört haben sollte.

Doch was sind eigentlich „TOPS”, „Tokens” oder „Batch Size”? Eine Erklärung, was diese Begriffe bedeuten und wie sie bei der Arbeit mit AI unterstützen, gibt es im heutigen AI-Decoded-Blog.

Einige Highlights des heutigen Blogeintrags:

TOPS-Leistung: Höhere TOPS (Trillions of Operations per Secon) bedeutet schnellere AI-Rechenleistung. Eine GeForce RTX 4090 bietet mehr als 1.300 TOPS, für ein optimales Erlebnis beim Spielen und höchste Effizienz für Kreative aller Art.

Tokens erklärt: Mit ihnen wird die Leistung von LLMs (Large-Language-Models), die ein zentraler Punkt vieler moderner AI-Systeme sind, gemessen.

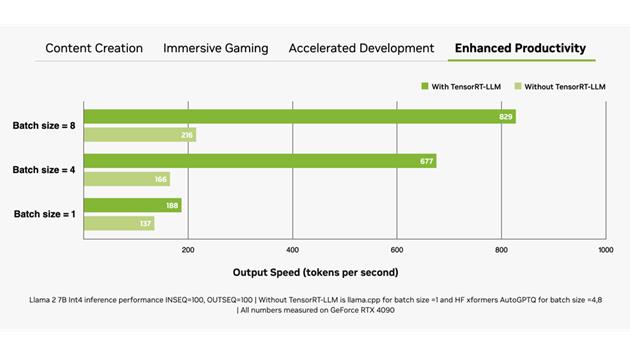

Mehr Inputs, schneller bearbeitet: Batch Size bestimmt die Menge an parallel bearbeiteten Inputs bei LLMs. Dabei gilt mit NVIDIA TensorRT-LLM Technologie: Je größer der Batch, desto mehr gesparte Zeit.

Schnellere Bilderstellung: RTX-GPUs beschleunigen beliebte AI-Modelle wie Stable Diffusion, wodurch die Text-zu-Bild- und Videoproduktion um bis zu 70 % beschleunigt wird.

Echte Beweise: Die Tests von Jan.ai zeigen, dass NVIDIAs TensorRT-LLM bis zu 70 % schneller ist als herkömmliche Lösungen, was die Effizienz von RTX-gestützter AI unterstreicht.

NVIDIA RTX- und GeForce-RTX-Technologien sind darauf ausgelegt, erstklassige Ergebnisse zu liefern - von beschleunigter Bildgenerierung bis hin zu verstärkter Leistung in Spielen.

Weitere Informationen gibt es im [l1|heutigen AI-Decoded-Blog].